Elkezdtük felébreszteni az alvó gépeket

A Google és a Facebook is új technológiába fektet be, amely reményeik szerint forradalmasítja a számítógépek és az internet működését. Mindkét vállalat csaknem egyszerre nyitott tavaly a "gépi mély tanulás", angol szakzsargonban újabban deep learning néven emlegetett technológia felé azzal, hogy szerződtették magukhoz a téma két igen jelentős szaktekintélyét. A Facebook csapatához a New York Egyetem professzora, Yann LeCun csatlakozott, a Google pedig a Kanadai Egyetem professzorát, Geoffrey Hintont alkalmazza félállásban. A keresőcég a hét elején a DeepMind nevű, mesterséges intelligenciával foglalkozó vállalatot is megvette.

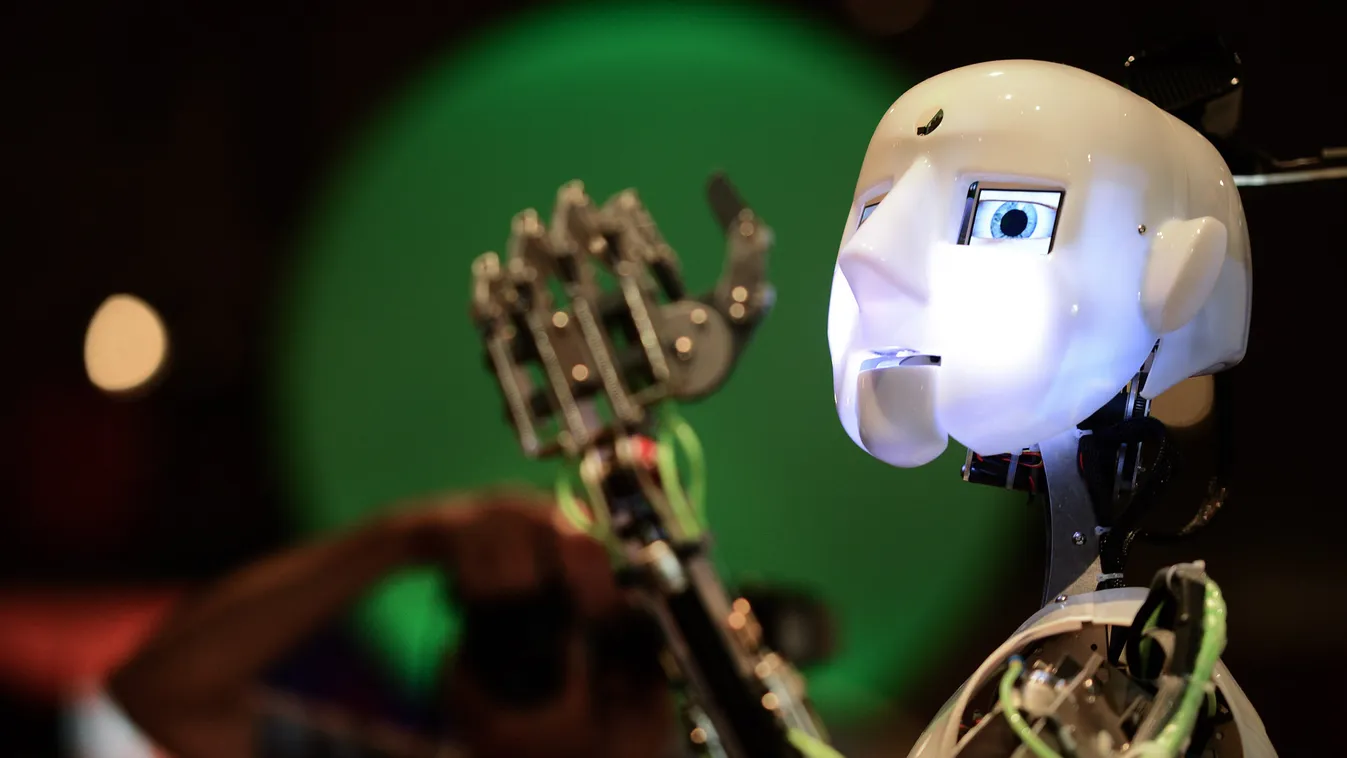

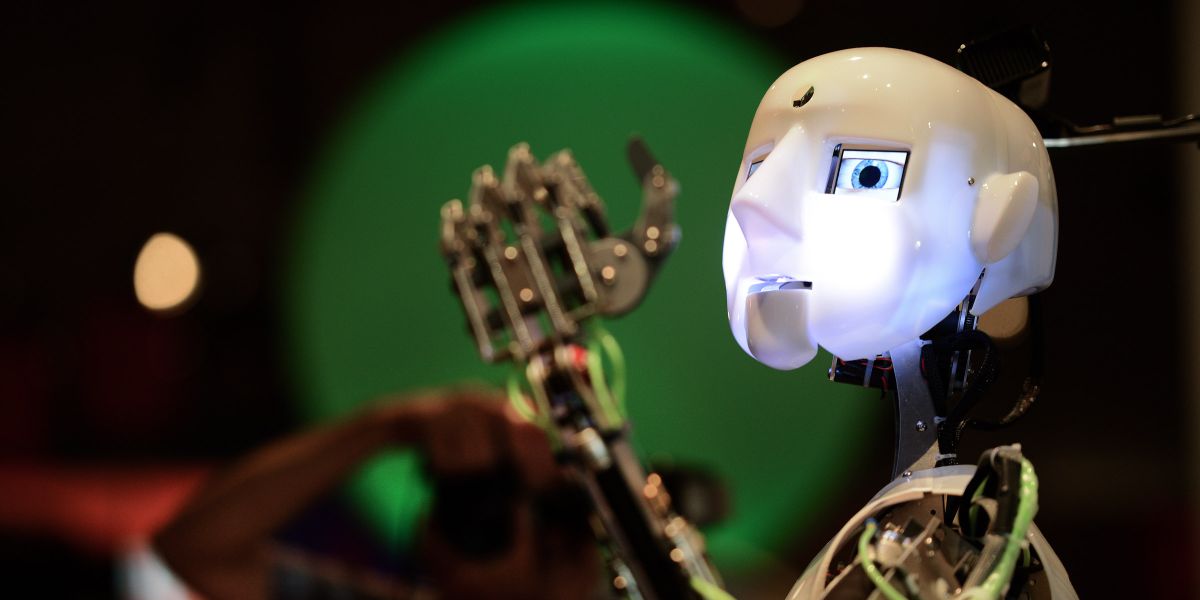

Hogy az okostelefonok már megértik az egyszerűbb parancsokat, a Wolfram Alpha keresővel pedig matematikai feladványokat is meg lehet oldani, jól mutatja, hogy nehéz pontosan meghatározni a mesterséges intelligencia fogalmát. Hernád István, egy kanadai és egy brit egyetemen is tevékenykedő idegkutató meghatározása szerint négy szintre lehet osztani az intelligens gépek fejlettségét annak alapján, hogy azok hogyan teljesítenének a gépek intelligenciájának mérésére kidolgozott Turing-teszten. Jelenleg az első szintnél tartunk - magyarázta az Origónak Sepp Norbert, az IBM műszaki szakértője.

Ezen az első szinten a robot még nem képes helyettesíteni egy embert - ehhez már a negyedik szintű fejlettség szükséges, ahol egy robotnak már érzelmei is lesznek -, ám bizonyos helyzetekben képes úgy viselkedni, mint egy ember. Például a Google robotautója már ugyanúgy halad, mint az ember vezette járművek, ám nem ismeri fel például, ha félre kell állni, mert valaki segítséget kér.

Az IBM Watson nevű szuperszámítógépét is gépi tanulási technológia alkalmazásával tették képessé arra, hogy angol nyelven már csaknem egy emberhez hasonlóan lehessen kommunikálni vele, akár beszédben, akár írásban. Ez a gép az amerikai Jeopardy kvízjátékban már három éve képes volt legyőzni egy emberi játékost.

A Google-on való keresés során a felhasználók még nem kérdéseket tesznek fel, hanem keresőszavakat használnak, amelyeket sokszor még írásjelekkel is strukturálni kell a megfelelő találatok előcsalogatásához. Ehhez képest az IBM mesterséges intelligenciája leképezi a kérdések értelmét általa is feldolgozható formátumúra, és az alapján kutat adatbázisában. A Watson alapját képező, tanulásra képes szoftvert - a fejlesztésen kívül - három évnyi munkával készítették fel a kvízjátékon való indulásra, mostanra azonban már orvosi diagnózisok felállításában és a kezelések hatékonyságának felmérésben segít orvosoknak a leletek és a kórtörténet elemzésével, jelentősen csökkentve az emberi hibák lehetőségét.

A számítógép megnyeri a vetélkedőt

Watson doktori tevékenységhez már csak másféléves szoftveres tréningre volt szükség. Intelligenciája ezen kívül pénzügyi befektetésekkel kapcsolatos tanácsadásra van felkészítve, de megtanították neki azt is, hogyan tud segíteni ügyfélszolgálatos munkatársakat az előfizetői kérdések minél gyorsabb és hatékonyabb megválaszolásában, a különböző Excel táblák és belsős honlapok böngészése helyett.

A nemrég a Google tulajdonába került DeepMind cég munkatásainak zöme komoly deep learninges múlttal rendelkezik - mondta az Origónak Kocsis Levente, a MTA SZTAKI adatbányászattal és keresőtechnológiákkal foglalkozó tudományos főmunkatársa, aki maga is ismer ott dolgozó szakértőket.

A deep learning kifejezés olyan algoritmusokat takar, amelyek az egyre nagyobb adattömeg (big data) hatékony és gyors feldolgozását teszik lehetővé. Mesterséges intelligenciát úgy is létre lehet hozni, hogy a lehetséges események millióira előre beprogramozzák a lehetséges válaszokat. Izgalmasabb módszer, ha csak az alapvető képességekkel látják el a gépet, amely egy csecsemőhöz hasonlóan, az alapoktól kezdi megszerezni az ismereteit. Ezek a gépek megfigyeléseikből és tapasztalataikból saját maguk vonnak le következtetéseket, így tulajdonképpen már nem programozni, hanem tanítani kell őket egy-egy specifikus terület kiismeréséhez.

A szakértő szerint a deep learning abban tér el a hagyományos gépi tanulástól, hogy több rétegben, vagyis több lépcsőben dolgozza fel a bejövő információt. Mindegyik réteg csak a maga feladatát végzi el, képfelismerés során például az egyik réteg csak a pixelek elhelyezkedését vizsgálja, egy másik pedig mondjuk az éleket keresi, és így tovább. Ebből a működési elvből adódóan a deep learninggel megvalósított mesterséges intelligenciák modelljének optimalizálása nagyon bonyolult, ami csak sok adattal lehetséges, és elég számításigényes.

A módszer alapelve már az 1960-as években is ismert volt, ám még húsz évvel később is annyira csekély mennyiségű adattal tudtak megbirkózni a számítógépek, hogy a megoldás nem terjedt el. Ekkoriban Yann LeCun már létrehozott egy olyan, az emberi idegsejt-hálózathoz hasonló elven működő számítógépes rendszert, amely képes volt kézzel írt irányítószámok felismerésére levelezőlapokon, bár a éles üzemre ekkor még ez sem volt alkalmas (noha a számok felismerését egyéb, primitívebb digitális módszerekkel is meg lehetet oldani). A tudományos szféra nem is volt túlságosan kíváncsi a deep learninggel kapcsolatos fejleményekre egészen a közelmúltig - LeCun, Hinton és egy Yoshua Bengio nevű, hasonló területen dolgozó kanadai tudós gyakorlatilag lelkesedésből foglalkozott a technológia fejlesztésével.

Az áttörésre csupán néhány éve került sor, hiszen napjainkban a Facebook, a Google vagy a Microsoft rendszereiben hatalmas adatmennyiségek raktározódnak, a szerverparkok és szuperszámítógépek pedig nagy feldolgozókapacitást nyújtanak. Nem véletlen, hogy a technológia élharcosait azonnal leszerződtették a legnagyobb internetes óriások. Kocsis Levente szerint a mély tanulás jelenleg a képfelismerés és a beszédfelismerés területén alkalmazható kiemelten hatékonyan, és a leginkább nagy számítási kapacitással és rengeteg adattal bíró - vállalatoknak érdemes használnia.

A deep learning segítségével már fel lehet ismertetni a gépekkel, ha egy fotón mondjuk egy béka látható - a képfelismerő algoritmusokat hasonló feladatokkal évente versenyeztetik- , de a pontos fajra való szűkítés még nem lehetséges. Az áttörést az jelenti majd, ha a számítógépes rendszerek teljesen nyers adatok értelmezésére lesznek képesek: ez lehetővé teszi majd azt, hogy például egy mozifilm nézése közben csak rábökjünk a főszereplő napszemüvegére, a gép azonnal kidobja annak márkáját és modelljét, vagy azt, hogy egy nagyváros melyik utcáján forgatták a jelenetet. Napjainkban még a vizuális tartalmak felismerése csak akkor hatékony, ha a képet vagy videót ellátják a tartalmára vonatkozó címkékkel is. Nem véletlen, hogy ha a Google-ba begépeljük mondjuk Galla Miklós nevét, akkor a humorista fotóin kívül a rendszer egy csomó olyan képet kilistáz, amelyeken teljesen más emberek vagy tárgyak láthatók (ezek valamilyen honlapon közös szövegkörnyezetben jelentek meg Gallával).

Az IBM szakértője szerint valószínűleg még évtizedeket kell várni arra, hogy a mesterséges intelligenciának érzelmei és szándékai legyenek.

Ugyanakkor már a mostani, első szintű intelligenciák is sokat segíthetnek az emberiségnek, hiszen attól, hogy egy robotautónak nincsenek saját gondolatai vagy érzései, még elvezethet egy járművet, akár egy emberi sofőrnél biztonságosabban is. Mark Zuckerberg, a Facebook alapítója a héten már úgy nyilatkozott, hogy tízéves távon belül számol azzal, hogy a mesterséges intelligencia meg fogja reformálni az internetet.

A Watson használatához mostanra már szuperszámítógépre sincs feltétlenül szükség - a kvízversenyen ez csak a néhány másodperces reakcióidő miatt kellett. Már a házi verzióját is tesztelik, de ezt sem tudjuk hazavinni a boltból: több millió forintos vállalati gépről van szó, amely bonyolult telepítést igényel, és üzemeltetéséhez is szakemberek szükségesek. Az IBM azonban néhány hete jelentette be azt is, hogy a Watsont felhőalapú szolgáltatásként is kínálni fogja. Ez azt jelenti, hogy hamarosan akár egy olcsó okostelefonon futó applikációval is emberi kommunikációt folytathatunk, ha az meghívja a cég mesterséges intelligenciáját. Nem véletlen, hogy ebből sem a Google, sem a Facebook nem akar kimaradni.