A kamupornó csak a kezdet volt, elkezdődött a videóhamisítás új korszaka

El tudja képzelni, hogy a Facebook vezetője, Mark Zuckerberg önként odaáll egy kamera elé, és elmondja, hogy mennyire helytelen dolog az, hogy több száz millió ember adatai és magánéletének részletei egy nagyhatalmú úrnál (nála) futnak össze, ő pedig ezzel rendkívül felelőtlenül bánik? Nem, mi sem tudjuk elképzelni, pedig látszólag megtörtént, és alább meg is tekinthető:

Azért csak látszólag történt meg a dolog, mert a videó hamis. Zuckerberg természetesen sosem mondana ilyeneket önszántából, főleg nem publikusan. Az eredmény mégis annyira meggyőző, hogy az ilyen hasonló videóknak nagyon sokan bedőlhetnek, és ez már csak rosszabb lesz. De mi ez a jelenség, hogyan kezdett el dübörögni a kamuvideók új korszaka?

Valójában a dolog még 2017-ben robbant fel először, amikor a Reddit egyik felhasználója "deepfakes" név alatt közzé tett egy olyan videót, amiben a Csodanő főszereplőjének, Gal Gadot-nak az arcát rátette egy pornószínésznőre. A végeredmény annyira hitelesnek tűnt, hogy innentől kezdve a jelenséget el is nevezték "deepfakes"-nek (ami magyarul a "mély" és a "kamu" szavakból tevődik össze).

Az elnevezés nem véletlen. Ahhoz ugyanis, hogy egy magánember egy ilyen minőségű videómanipulációt végre tudjon hajtani, vagy rendkívül profi grafikusnak kell lennie, és több száz munkaórát beleölnie (és valószínűleg még akkor sem lesz túl meggyőző a végeredmény), vagy valami más trükkhöz folyamodnia. A Reddit felhasználója esetében az utóbbi történt:

a mesterséges intelligencia egy formáját, a mélytanulásos (deep learning) technológiát vetette be, ráadásul olyan, ingyenesen hozzáférhető gépi tanulásos eszközök segítségével, mint a Google-féle TensorFlow.

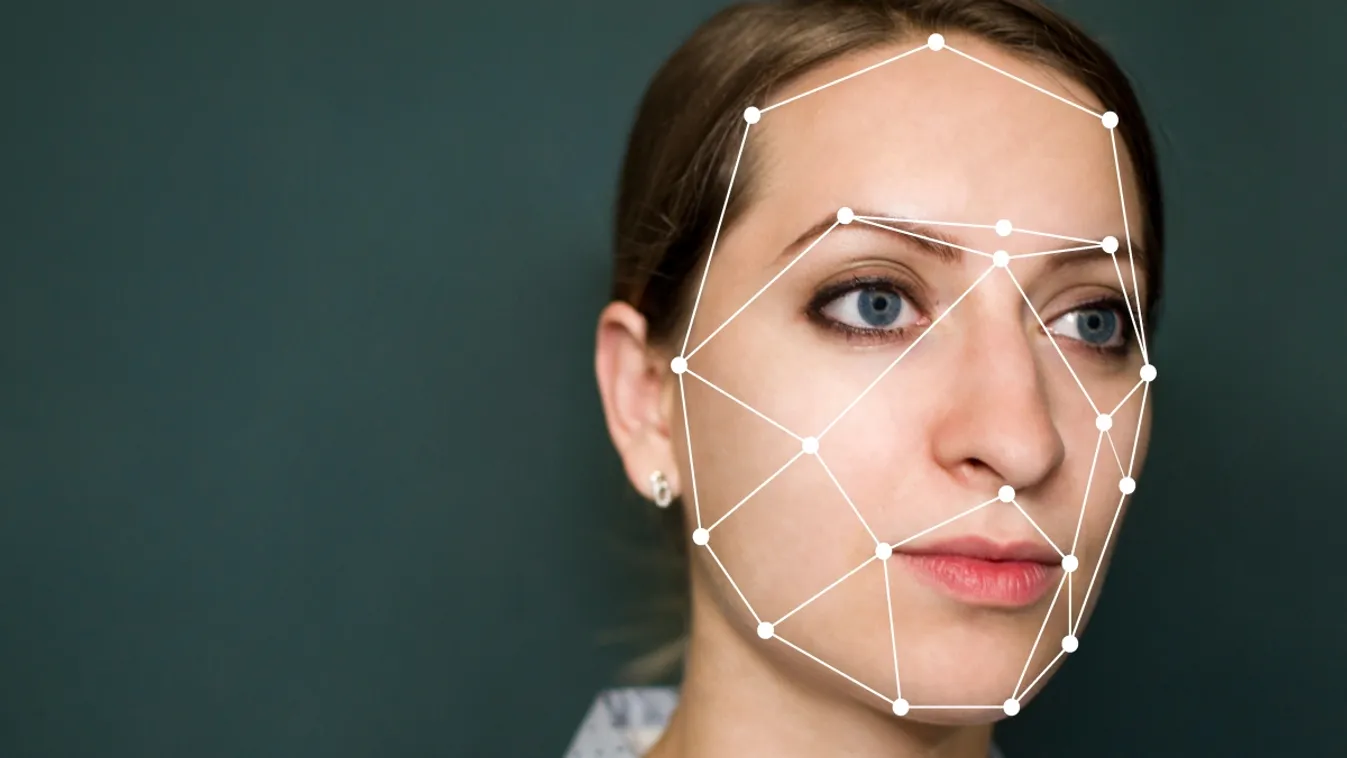

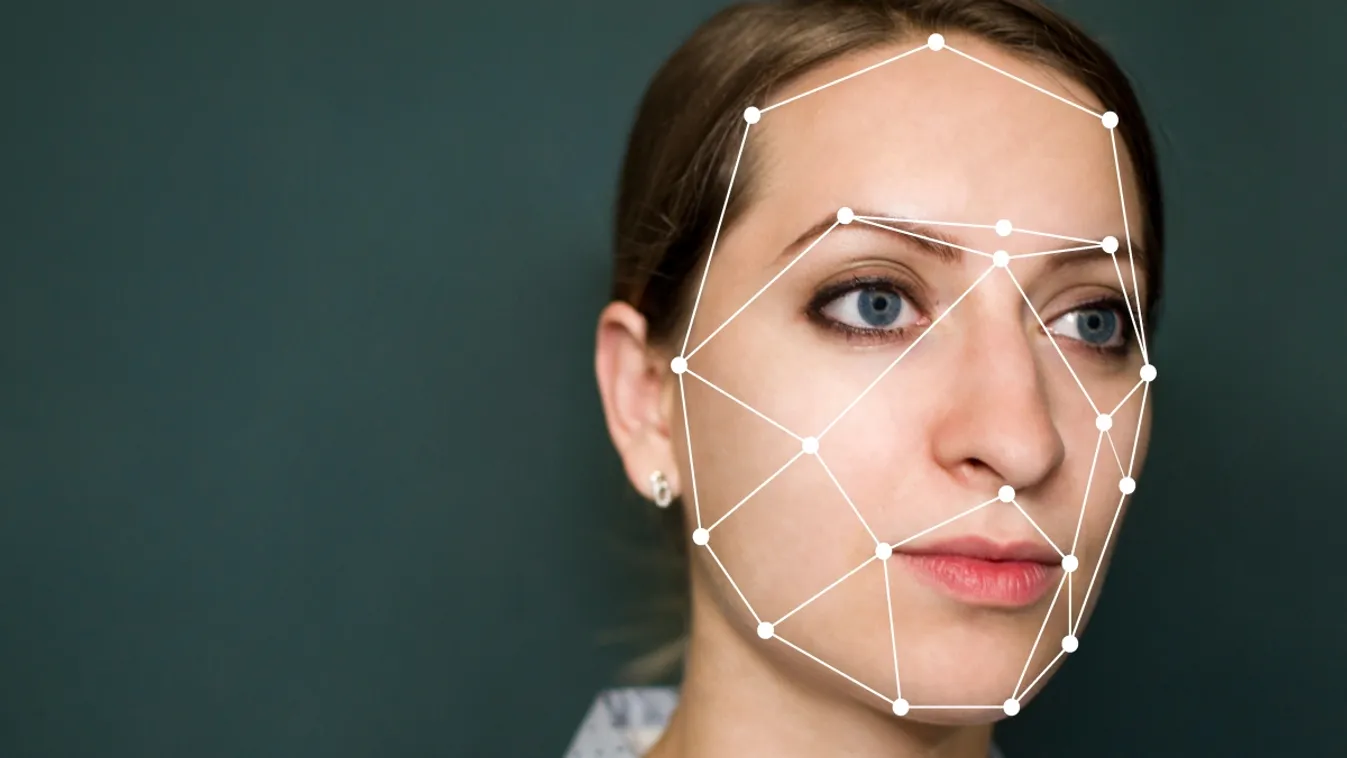

Az tehát nem újdonság, hogy valaki egy celeb arcát rámontírozza egy pornóra (vagy bármi másra). Az viszont igen, hogy a valóságtól szinte megkülönböztethetetlen végeredményt tud elérni, otthoni körülmények között, egy mezei számítógépen. A dolog lényege ugyanis az, hogy a mesterséges intelligenciával meg kell etetni minél több videós és képes anyagot a kiszemelt személyről, hogy az mélyen elemezni tudja annak arcát, minden rezdülésével, mimikájával, mozgásával együtt.

Ezt követően pedig már annyira ismeri ennek a bizonyos személynek az arcát, hogy azt szinte bármilyen más arc helyére be tudja helyettesíteni úgy, hogy minden stimmelni fog.

Az egész jelenség aztán akkor robbant fel másodszor, amikor 2018-ban egy külön letölthető számítógépes alkalmazás is megjelent FakeApp néven, ami aztán még egyszerűbbé tette, hogy otthoni körülmények között szinte bárki tudjon manipulált videókat készíteni. Úgyhogy nem is kellett sokat várni, boldog-boldogtalan belevágott a dologba, a hollywoodi színésznők arcai egyre gyarapodtak a pornófilmekben, de akadtak azért olyan szellemes próbálkozások is, mint az alábbi videó, amiben Nicholas Cage arcát helyettesítették be mindenféle filmbe:

Gyorsan kiderült persze az is, hogy a deepfake segítségével bosszúpornót is viszonylag könnyen lehet készíteni (ha például a volt párunkról, vagy akivel ki szeretnénk szúrni, elég videós és fényképes anyaggal rendelkezünk), így a legnagyobb oldalak elkezdték kitiltani az ezzel a technológiával készült videókat, még a legnagyobb pornóoldal, a PornHub is besokallt.

Arra azonban még pár hónapot várni kellett, hogy valaki igazán rámutasson, milyen veszélyes vizekre lehet evezni a deepfake videókkal.

A BuzzFeed nevű technológiai oldal közzétett egy videót, melyen Barack Obama előző amerikai elnök szerepel, és amelyben igen trágár szavakkal illeti Donald Trump jelenlegi elnököt. Ezeket a szavakat Obama sosem mondta ki, sosem mondott ilyen beszédet, az egész mégis teljesen realisztikus, és mindössze 56 órájába került a FakeApp alkalmazásnak, hogy elkészítse.

Innentől pedig a technológiai biztonsági szakértők elég sötét jövőképet kezdtek el felvázolni: amikor bármilyen magas befolyású emberrel el lehet mondatni bármit, és az megkülönböztethetetlen a valóságtól, akkor alapvetően két dolog történhet. Az egyik, hogy az emberek inkább nem néznek meg, vagy nem hisznek el egy videót sem, ami ahhoz vezet (például politikusok bejelentései, nyilatkozatai kapcsán), hogy kevésbé lesznek tájékozottak.

A másik, hogy vajon mi történik akkor, ha például az amerikai elnökről közzétesznek egy kamu videót, amiben bejelenti, hogy nukleáris csapást mér mondjuk Észak-Koreára?

Az Egyesült Államokban hamar fel is figyelt a jelenségre a törvényhozás, és miután a képviselőház meghallgatott több szakértői véleményt is a deepfakesszel kapcsolatban, úgy döntöttek, hogy alaposan kivizsgálják az ezzel kapcsolatos potenciális nemzetbiztonsági veszélyeket, és kitalálják, hogyan lehetne védekezni ellene. Mint mondták, meg kell fejteniük, hogy milyen szerep jut majd a közszférának, a privát szektornak és a társadalomnak egy "igazság utáni jövőben".

Persze, ha valamit létre lehet hozni a technológia segítségével, azt le is lehet buktatni azáltal, ugye?

Nos, jelenleg az a helyzet, hogy nem igazán, és a deepfake-videók leleplezésére használható megoldások jelenleg nem túl megbízhatóak. Siwei Lyu, a New York-i Állami Egyetem szakértője például elmondta, hogy az általuk kifejlesztett technológia azt veszi alapul, hogy a deepfake-videókban nagyon keveset (vagy egyáltalán nem) pislog a szereplő, azonban ennek sem lesz sok haszna, amikor valakiről a mesterséges intelligencia egyre több olyan anyagot dolgoz fel, amiben pislog.

A helyzet tehát tulajdonképpen a szokásos: egy adott technológia önmagában se nem rossz, se nem jó, minden attól függ, hogy ki és mire használja. Hatalmas botrány, vagy visszavonhatatlan sérülés eddig még nem keletkezett a deepfake nyomán, viszont olyan vicces videók igen, amiben például Jon Snow, a Trónok harca egyik főszereplője kér elnézést a sorozat utolsó évadának silány minőségéért:

Vagy például ott van a Ctrl Shift Face nevű YouTube-csatorna, aminek a készítői azzal vannak elfoglalva, hogy meglévő filmekben kicserélik a főszereplők arcát más híres színészére, és ezt igyekeznek a lehető legjobb minőségben megtenni. Különösen szórakoztató például Jim Carrey a Ragyogás főszereplőjeként, Jack Nicholson helyett:

Jelenlegi ismereteink szerint most ez a deepfake csúcsa, a videók többségében tényleg nem, vagy alig lehet megmondani, hogy manipuláció történt.

Ami persze felvet egy másik kérdést is: vajon meddig lesz még szükség színészekre?