Mielőtt a robotok végleg átveszik felettünk a hatalmat

Hetven évvel ezelőtt Isaac Asimov elképzelt egy világot, amelyben a robotok megszámlálhatatlan különböző módon szolgálják az emberiséget. A híres sci-fi-szerző arról sem feledkezett meg, hogy a robotokat beépített biztonsági garanciákkal szerelje fel.

A robotika Asimov-féle törvényeiként ismertté vált szabályok egyebek között azt írják elő,

hogy egy robot sosem árthat az embereknek.

A gépek biztonságos és igazságos működésének kérdése, amely akkor még a tudományos fantasztikum birodalmába tartozott, mára égető aktualitássá érett.

A mesterséges intelligencia (MI) már rég nem csak a tudományos kutatás játékszere,

hanem mindennapjaink elválaszthatatlan része: a gépi tanuló algoritmusoknak köszönhetően a számítógépek ma már az autóvezetéstől a robotok irányításán át az automatizált döntéshozásig bármilyen feladatot el tudnak látni.

Ám amint olyan érzékeny kérdésekben is kezdjük átadni nekik a kontrollt, mint hogy egy vádlott őrizetből vagy szabadlábon védekezhessen-e, egyre többen sürgetik az olyan biztosítékok beépítését, amelyek garantálják, hogy az MI nem kockáztat emberéleteket, és elfogulatlanul, származási és nemi előítéletektől mentesen ítélkezik.

A Stanford Egyetem és a Massachusetts-i Egyetem kutatói által vezetett csoport a Science legfrissebb számában tett közzé egy cikket, amelyben felvázolják, miként lehetne az MI-t ilyen biztosítékokkal ellátni. A szerzők által javasolt új technika az olyan egzakt módon nehezen körvonalazható elvárásokat, mint hogy „kerüld el a nemek szerinti részrehajlást", precíz matematikai kritériumokká alakítja.

Olyan utasításokká, amelyek egy gépi tanuló algoritmusba építve garantálják a nem kívánt viselkedés elkerülését. „Olyan MI-t javaslunk, amely tiszteletben tartja emberi felhasználóinak értékrendjét, így rászolgál arra a bizalomra, amelyet az önműködő rendszerekbe helyezünk" – foglalta össze Emma Brunskill, a Stanford komputertudósa és a cikk rangidős szerzője.

A munka abból az alapfeltevésből indult ki,

hogy a „nem biztonságos" és a „nem igazságos" viselkedés valamiképp matematikai módon is leírható,

s ha ez így van, lehetséges olyan algoritmusokat alkotni, amelyek a bemenet alapján megtanulják az ilyen viselkedések elkerülését.

A kutatók szerettek volna továbbá olyan technikákat létrehozni, amelyek révén a felhasználó egyszerűen meg tudja határozni

az adott alkalmazásban nemkívánatos viselkedések körét.

A cél az volt, hogy a gépi tanuló algoritmusok tervezői nagy biztonsággal kimondhassák: a múltbéli adatokon keresztül betanított rendszerük megbízható marad a valós szituációkban is.

„Mi megmutatjuk, hogyan segíthetnek a gépi tanuló algoritmusok tervezői azoknak, akik MI-t szeretnének beépíteni a termékeikbe és szolgáltatásaikba; hogyan könnyíthetik meg a számukra a nemkívánatos kimenetelek és viselkedések leírását, amelyeket aztán az MI-vezérelt rendszerek nagy valószínűséggel elkerülnek" – fogalmazott Philip Thomas, a Massachusetts-i Egyetem Amherst kampuszának komputertudományi előadója és a cikk írója.

A kutatók egy olyan MI-algoritmus előítélet-mentesítésével tesztelték a módszerük működőképességét, amelyet Amerikában elterjedten használnak arra, hogy a college-ba járó diákok záró tanulmányi átlagát a vizsgaeredményeik alapján megjósolják.

Ezek az algoritmusok ismerten torzítanak a diák neme szerint.

Egy kísérleti adatbázist bemenetnek használva olyan matematikai utasításokat adtak az algoritmusnak, amelyek nem engednek az egyik vagy másik nem felé módszeresen részrehajló prediktív módszert kifejleszteni.

Az utasítások segítségével az algoritmus olyan módszert azonosított, amely nem csak hogy az eddigieknél megbízhatóbb jóslásokat ad, de sokkal kevésbé hajlamos a nem szerinti torzításra.

A korábbi módszerek nem teljesítettek jól e téren, mert vagy nem is rendelkeztek beépített igazságosság-szűrővel, vagy az elfogulatlansági garanciáik túlságosan leegyszerűsítő algoritmusokra épültek.

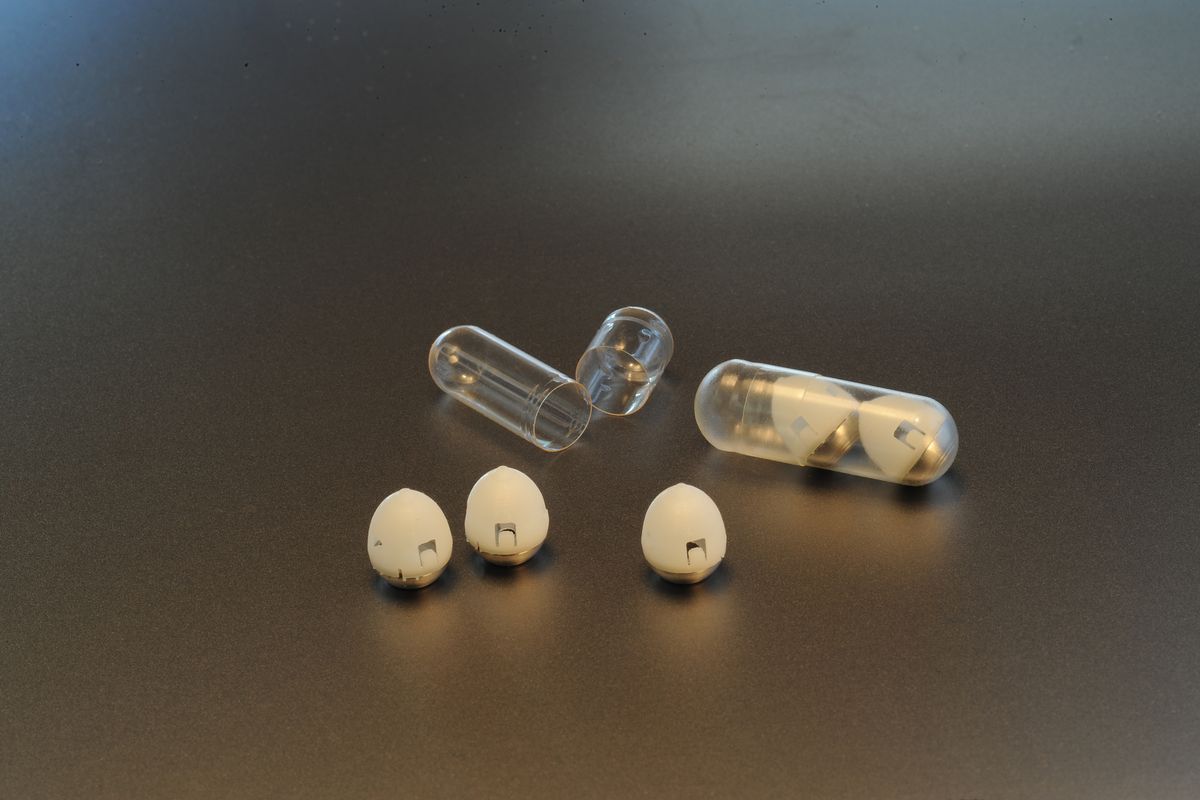

A csoport kifejlesztett egy másik algoritmust is, amely egy automatikus inzulinadagoló pumpát vezérelt a biztonságosság és a teljesítmény egyidejű figyelembe vételével.

Ezeknek a pumpáknak az a feladatuk, hogy étkezés után eldöntsék, milyen inzulindózist adnak viselőjüknek.

Ideális esetben a pumpa éppen annyi inzulint ad le, amennyi elegendő a vércukorszint állandóan tartásához.

Ha ennél kevesebbet adagol, a vércukorszint megugrik, ami nem csak rövidtávú kellemetlenségekhez – például hányingerhez – vezet, de hosszú távon növeli a különböző szövődmények, például a keringési betegségek kockázatát.

Ha viszont többet mér ki a kelleténél, a vércukorszint lezuhan, ami akár végzetes kimenetelű is lehet.

A gépi tanulás kétségtelenül sokat segít ebben a feladatban azzal, hogy finom összefüggés-mintázatokat keres a leadott dózisok és a vércukorszintben bekövetkező változások között, s ezek segítségével a működést az adott használóra optimalizálja.

Viszont a ma használatos algoritmusok egyike sem kínál kézenfekvő lehetőséget az orvosok számára, hogy az automatikus adagoló algoritmusba beprogramozzák a nemkívánatos kimeneteleket, mint amilyen a hirtelen vércukorszint-zuhanás.

Brunskill és Thomas egy vércukorszint-szimulátor segítségével megmutatta, hogyan lehet a pumpának betanítani a személyre szabott adagolást úgy,

hogy a túl- és aluladagolásból adódó komplikációkat elkerülje.

Bár a csoport még nem kész arra, hogy az algoritmust valódi embereken is magabiztosan tesztelje, kijelöli az utat az MI-fejlesztők számára a cukorbetegek életminőségét javító megoldások felé.

A Science-cikk szerzői Asimov előtt tisztelegve „seldoni"-nak nevezik az algoritmusaikat. Ezzel Asimov regényszereplőjére, Hari Seldonra utalnak, aki a robotika három törvényét kihirdeti.

A törvények megfogalmazása így kezdődik:

Robot emberi lénynek sosem árthat, és tétlenségével nem engedheti, hogy egy emberi lénynek baja essék."

Miközben elismeri, hogy

az MI-nek még hosszú utat kell megtennie a három törvény garantált teljesüléséig,

Thomas szerint az általuk kidolgozott seldoni keretrendszer megkönnyíti majd a gépi tanuló algoritmusok tervezőinek a viselkedés-elkerülő utasítások beépítését.

Az új algoritmusok révén a programozók számszerűen meg tudják majd becsülni,

hogy a betanított rendszerek milyen valószínűséggel működnek majd az elvárásoknak megfelelően a való világban.

Brunskill hozzátette: a keretrendszer számos más komputertudós erőfeszítéseire is épít, akik mind azon dolgoznak, hogy egyensúlyt teremtsenek az algoritmusok teljesítőképessége és megbízhatósága között.

„Ahogy a társadalom egyre inkább támaszkodik az MI-re, alapvető fontosságú azon gondolkodnunk, hogyan alkothatunk a biztonság és az igazságosság értékeit leginkább szem előtt tartó algoritmusokat" – szögezte le a kutató.